预训练语言模型技术论坛@CNCC | 数图回看

导读:以BERT和GPT为代表的预训练语言模型自从2017年提出以来取得了巨大的成功,改变了整个自然语言 处理的面貌,几乎刷新了所有自然语言处理任务的成绩,而且在工业界也开始获得广泛的应用,其影响甚至远 远超出了NLP的范围。最近新出现的GPT-3模型更是表现出了惊人的能力,似乎再一次印证了“大力出奇迹” 这样一个道理。

讲者:孙宇 百度杰出架构师,百度语义理解技术与平台ERNIE负责人

简介:预训练语言模型在自然语言处理领域发展迅速并获得广泛工业应用。2019年,百度提出了101知识增强语义理解框架文心(ERNIE),在GLUE评测中以首次突破90分的水平位居全球第一。此后,百度文心(ERNIE)取得一系列突破和应用,在多个权威语义评测中获得近十项世界冠军。文心被包括全球顶级科技商业杂志《麻省理工科技评论》等多国权威科技媒体报道,在2020世界人工智能大会上赢得最高荣誉SAIL奖。本次报告主要分享百度文心(ERNIE)在技术创新及产业应用方面的进展。

讲者:邱锡鹏 复旦大学计算机科学技术学院教授

简介:目前预训练语言模型在自然语言处理领域取得了广泛的成功,并改变了自然语言处理的学习范式。未来预训练语言模型还会取得什么样的突破?有没有更高效的学习范式出现?本报告的内容简单总结预训练语言模型目前的一些改进方向,包括迁移方法、知识嵌入、多模态、跨语言、特定领域等,并对预训练模型的未来发展趋势进行展望。

讲者:尚利峰 华为诺亚方舟实验室高级研究员

简介:主要介绍华为诺亚方舟实验室语音语义团队在预训练语言模型方向上的研究和商业化探索,以及我们对该研究未来发展方向的思考。我们最近的研究主要关注在预训练语言模型的解释分析,设计更加高效的预训练任务,融合蒸馏/量化等多种技术的高效压缩,以及我们在自然语言理解等多个业务场景的落地尝试。在未来发展发向上,我们关注在提升预训练语言模型的知识表示和推理能力,推进依赖推理的信息检索系统的发展。

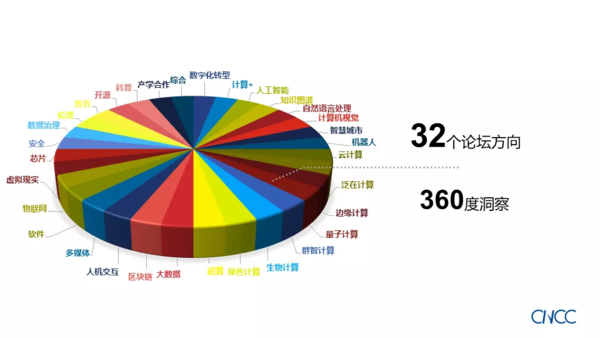

经CNCC2021组织机构以及主办方研究决定, CNCC2021确定延期至2021年12月16-18日举办,地点仍为深圳国际会展中心。今年CNCC大会主题是“计算赋能加速数字化转型”。今年的特邀嘉宾包括ACM图灵奖获得者John Hopcroft教授和Barbara Liskov教授,南加州大学计算机科学系和空间研究所Yolanda Gil教授,陈维江、冯登国、郭光灿、孙凝晖、王怀民等多位院士,及众多深具业内影响力的专家。

CNCC2021将汇聚国内外顶级专业力量、专家资源,为逾万名参会者呈上一场精彩宏大的专业盛宴。

返回首页

返回首页