本期发布术语热词:对抗样本(Adversarial Sample/Example)

对抗样本

(Adversarial Sample/Example)

作者:陈恺、赵月(中国科学院信息工程研究所)

InfoBox:

中文名:对抗样本

英文名:

Adversarial Sample/Example

学科:网络空间安全

定义:对抗样本是指通过在数据中故意添加细微的扰动生成的一种输入样本,能够导致神经网络模型给出一个错误的预测结果。

实质:对抗样本是通过向输入中加入人类难以察觉的扰动生成,能够改变人工智能模型的行为。其基本目标有两个,一是改变模型的预测结果;二是加入到输入中的扰动在人类看起来不足以引起模型预测结果的改变,具有表面上的无害性。对抗样本的相关研究对自动驾驶、智能家居等应用场景具有非常重要的意义。

背景与动机

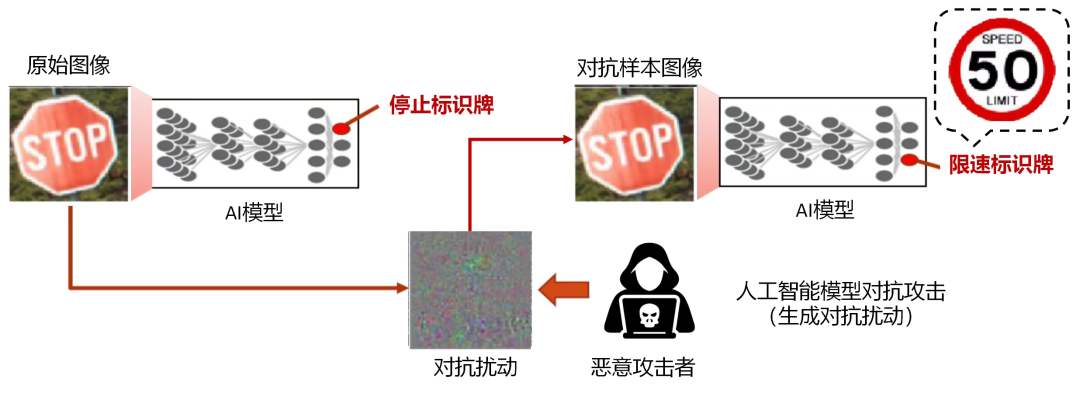

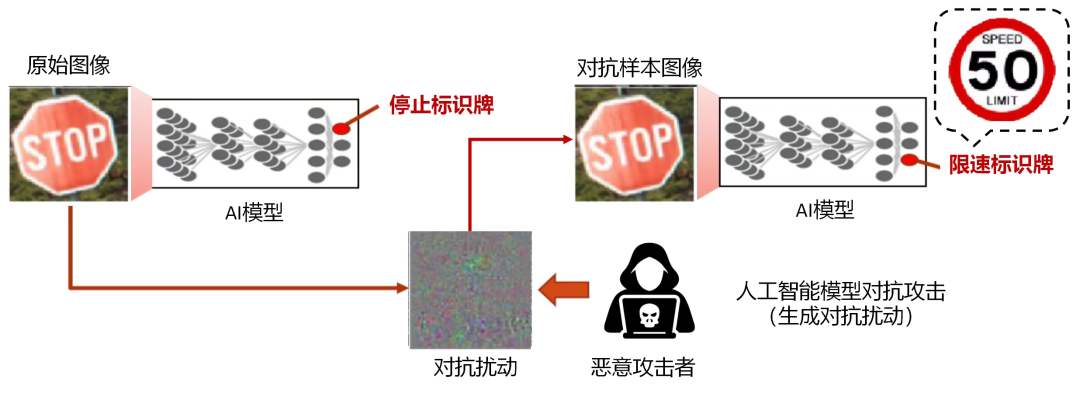

人工智能技术越来越多地进入到人类社会,尤其是应用在一些安全攸关的场景,对抗样本可能引发严重的安全问题。图1所示是一张“停止”交通标识牌的图像,在添加对抗扰动之后,在人类眼中依旧是“停止”标识牌,但是能够使得人工智能模型将其识别为“限速”标识牌。如果对抗样本被用来攻击自动驾驶的感知系统,则会威胁人们的生命和财产安全。研究对抗样本,一方面能够对其进行防御,保护模型的安全;另一方面,也能够一定程度上启发研究人员深入认识和理解神经网络,辅助神经网络模型的相关研究和应用。

图1 对抗样本示例

研究概况

1)对抗攻击

对抗攻击旨在研究对抗样本生成算法,包括:研究如何生成攻击成功率高且难以被人类发现异常的对抗样本[1,2];研究在特定场景下(如黑盒场景[3,4]、物理域攻击场景[5-7])如何生成对抗样本等。近年来,对抗攻击的研究也从最初的分类模型拓展到多个方面,例如对可解释性算法的攻击[8]、对缩放算法的攻击[9]等。

2)对抗防御

对抗防御旨在研究如何消除对抗样本带来的威胁。这方面的研究很多是经验性的,例如对抗样本的检测[10]、对抗样本的净化[11]等。对抗性训练[12]是一种常用的防御方法,能够在训练过程中增强模型的鲁棒性。目前,寻找同时能够保证较高的模型鲁棒性和泛化性的对抗训练算法仍是研究难点。可证明鲁棒性[13]尝试从理论上保证模型在一定扰动范围内不受到对抗样本的影响。

未来展望

虽然关于对抗样本的研究越来越多,但是仍然存在挑战。例如:如何生成有效的物理域攻击样本,如何设计具有理论保证且更实用的对抗样本防御方法。这些研究能够帮助我们深入认识神经网络,寻找应用过程中可能存在的安全威胁,让神经网络更加可信。随着人工智能模型逐步应用到人们的现实生活,关于对抗样本的研究也会变得越来越重要。

参考文献:

[1]Madry A, Makelov A, Schmidt L, et al. Towards deep learning models resistant to adversarial attacks[J]. arXiv preprint arXiv:1706.06083, 2017.[2]Carlini N, Wagner D. Towards evaluating the robustness of neural networks[C]// In IEEE Symposium on Security and Privacy (SP). 2017: 39-57.[3]Chen P Y, Zhang H, Sharma Y, et al. Zoo: Zeroth order optimization based black-box attacks to deep neural networks without training substitute models[C]//Proceedings of the 10th ACM workshop on artificial intelligence and security. 2017: 15-26.[4]Xie S, Wang H, Kong Y, et al. Universal 3-dimensional perturbations for black-box attacks on video recognition systems[C]// IEEE Symposium on Security and Privacy (SP). 2022: 1390-1407.[5]Zhao Y, Zhu H, Liang R, et al. Seeing isn’t believing: Towards more robust adversarial attack against real world object detectors[C]//Proceedings of the 2019 ACM SIGSAC Conference on Computer and Communications Security. 2019: 1989-2004.[6]Chen Y, Yuan X, Zhang J, et al. Devil’s Whisper: A General Approach for Physical Adversarial Attacks against Commercial Black-box Speech Recognition Devices[C]//USENIX Security Symposium. 2020: 2667-2684.[7]Yuan X, Chen Y, Zhao Y, et al. Commandersong: A systematic approach for practical adversarial voice recognition[C]//In 27th USENIX Security Symposium (USENIX Security 18). 2018: 49-64.[8]Zhang X, Wang N, Shen H, et al. Interpretable deep learning under fire[C]///In 29th USENIX Security Symposium (USENIX Security 20). 2020.[9] Quiring E, Klein D, Arp D, et al. Adversarial preprocessing: Understanding and preventing image-scaling attacks in machine learning[C]///In 29th USENIX Security Symposium (USENIX Security 20). 2020: 1363-1380.[10]Yang Y, Gao R, Li Y, et al. What you see is not what the network infers: detecting adversarial examples based on semantic contradiction[J]. arXiv preprint arXiv:2201.09650, 2022.[11]Jia X, Wei X, Cao X, et al. Comdefend: An efficient image compression model to defend adversarial examples[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2019: 6084-6092.[12] Bai T, Luo J, Zhao J, et al. Recent advances in adversarial training for adversarial robustness[J]. arXiv preprint arXiv:2102.01356, 2021.[13] L. Li, T. Xie and B. Li, "SoK: Certified Robustness for Deep Neural Networks," In IEEE Symposium on Security and Privacy (SP) , San Francisco, CA, US, 2023 pp. 94-115.计算机术语审定委员会(Committee on Terminology)主要职能为收集、翻译、释义、审定和推荐计算机新词,并在CCF平台上宣传推广。这对厘清学科体系,开展科学研究,并将科学和知识在全社会广泛传播,都具有十分重要的意义。

术语众包平台CCFpedia的建设和持续优化,可以有效推进中国计算机术语的收集、审定、规范和传播工作,同时又能起到各领域规范化标准定制的推广作用。

新版的CCFpedia计算机术语平台(http://term.ccf.org.cn)将术语的编辑运营与浏览使用进行了整合,摒弃老版中跨平台操作的繁琐步骤,在界面可观性上进行了升级,让用户能够简单方便地查阅术语信息。同时,新版平台中引入知识图谱的方式对所有术语数据进行组织,通过图谱多层关联的形式升级了术语浏览的应用形态。

主任:

刘 挺(哈尔滨工业大学)

副主任:

王昊奋(同济大学)

李国良(清华大学)

主任助理:

李一斌(上海海乂知信息科技有限公司)

执行委员:

丁军(上海海乂知信息科技有限公司)

林俊宇(中国科学院信息工程研究所)

兰艳艳(清华大学)

张伟男(哈尔滨工业大学)

委员:

柴成亮(北京理工大学)

彭鑫(复旦大学)

李博涵(南京航空航天大学)

李超(上海交通大学)

李晨亮(武汉大学)

杨敏(中国科学院深圳先进技术研究院)

张鹏(天津大学)

王昌栋(中山大学)

张宁豫(浙江大学)

孔祥杰(浙江工业大学)

术语投稿热线:ccfpedia@ccf.org.cn

返回首页

返回首页