联手信息系统专业委员会:“事件密集型图文跨模态检索”术语发布 | CCF术语快线

本期发布术语热词:事件密集型图文跨模态检索(Cross-Modal Retrieval between Event-Dense Text and Image)。

事件密集型图文跨模态检索

(Cross-Modal Retrieval between Event-Dense Text and Image)

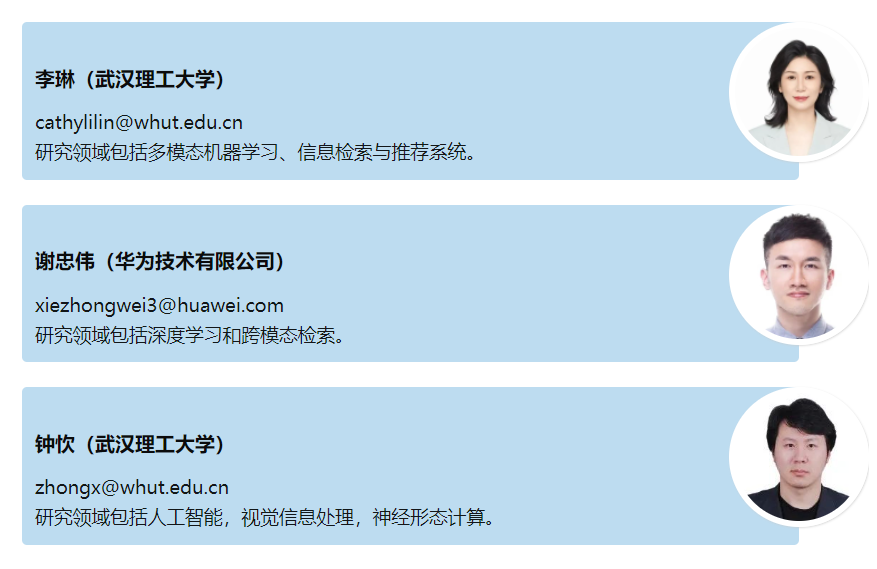

作者:李琳(武汉理工大学)、

谢忠伟(华为技术有限公司)、

钟忺(武汉理工大学)

开篇导语

随着跨模态图文检索工作应用到不同行业领域中,查询文本呈现出篇章级的长度。篇章级文本大部分存在着事件密集的特点,是跨模态图文检索的研究热点之一。事件密集文本与图像的跨模态检索任务是给定一个查询图像(呈现了多个事件发生的结果),检索得到的文本描述事件发生的过程;相反,给定一个查询文本(描述了多个事件发生的过程),检索得到的图像展示事件发生的结果。人工智能技术的发展和社会需求的产生,大力推动高质量篇章级图文跨模态检索方法的研究,并促进多模态机器学习在数字经济多场景的发展和应用。

InfoBox:

中文名:事件密集型图文跨模态检索

外文名:Cross-Modal Retrieval between Event-Dense Text and Image

学科:信息检索

实质:事件密集型特点给篇章级跨模态检索带来了新的问题。事件密集型文本中包含多个事件内容信息,例如用户在社交平台上传的食谱文本中每一个操作步骤可视为一个事件。由此出现,事件之间存在复杂关系、图像是多个事件发生结果的视觉呈现、以及事件发生顺序不同产生差异性的结果图像等一系列新问题,使得篇章级跨模态图文检索任务更具有挑战性。

背景与动机:

跨模态检索是跨媒体理解的重要方向之一,研究场景是以一种模态数据作为查询,检索与之语义相关/匹配的其他模态数据。随着社交媒体和互联网应用上的多模态数据爆炸式增长,跨模态检索任务在多模态研究社区中吸引了广泛注意。例如,游客通过手机拍摄的景点照片检索文本和音频等观光指南,获取模态多样的检索结果。因此,不同模态的数据可共同描述一个事物,丰富了事物蕴含的语义信息,促进了人们对信息的获取与理解。

跨模态检索任务主要分为基于图像和文本的跨模态检索、基于图像的视频检索和基于文本和音频的跨模态检索等。面向视觉图像和自然语言文本,以图索文和以文索图是跨模态检索的典型任务,描述图像内容的文本从传统的单词级(word level),发展到句子级(sentence level),如今出现了篇章级(document level),给图文跨模态检索带来了新的问题与挑战。1) 篇章级文本的涌现亟需提高多模态表示学习质量:单张图像的视觉内容难以与篇章级文本内容精准对应和对齐,导致在共同语义空间中图文特征表示学习及语义匹配欠准确;2) 事件密集型特点给篇章级跨模态检索带来了新的问题:事件密集型文本中包含多个事件内容信息、事件之间存在复杂关系、图像是多个事件发生结果的视觉呈现,以及事件发生顺序不同产生差异性的结果图像等。可以看到篇章级跨模态图文检索任务更具有挑战性,在新闻配图、事件报道、服装加工和食谱检索等不同行业领域具有广阔的应用前景。

研究概况:

随着Recipe1M大规模事件密集食谱数据集的发布[1],篇章级文本的跨模态图文检索研究主要分为三类,分别是基于模态匹配的方法、基于模态迁移的方法和基于模态重建的方法。现有研究围绕事件密集型的特点从事件文本表示、事件语义分析和图文语义对齐等角度开展。

(1) 基于模态匹配的方法(Modality Matching based Methods)

借鉴单词级和句子级图文跨模态检索的成果,篇章级任务持续重点研究共同潜在语义空间的图文模态特征表示学习。Salvador等人[1]提出用LSTM学习句子级文本表示,利用预训练ResNet-50形成图像特征表示,并建立了基于模态匹配的跨模态检索框架(Joint Embedding with Semantic Regularization, JESR),为后续的研究工作打下了基础。Lien等人[2]通过Google搜索引擎解决食谱中食材原料造成的信息损失问题以及食谱文本描述不够准确的问题。Carvalho等人[3]在JESR模型的基础上融合了耦合三元组损失函数,提出了基于自适应挖掘策略的联合表示学习模型。Chen等人[4]进一步挖掘文本中的标题信息,基于JESR模型提出了结合注意力机制和语义约束的联合表示学习。Pham等人[5]在文本表示学习中利用Tree-LSTM网络学习篇章级文本句子之间的层级结构信息。Wang等人[6]在文本表示学习上结合自注意力机制关注文本中的重要信息。Xie等人[7-8]通过原料、动作和标签抽取增加事件文本的表示学习质量。

(2) 基于模态迁移的方法(Modaility Transfer based Methods)

模态表示学习过程中不同模态之间的信息迁移可以缓解模态鸿沟问题,通常做法是在文本特征和图像特征映射到共同潜在语义空间之前,选择在一个模态表示学习过程中自动融入另一种模态数据的信息。SN方法[9]和HF-ICMA方法[10]均采用了自注意力机制,在模态表示学习过程中将另一种模态特征表示作为查询向量来促进模态对齐。为了进一步加强训练过程中文本与图像之间的模态交互,Li等人[11]将文本与图像数据同时输入到基于Transformer网络的度量模型中,最后输出图文数据对的相似度值。Han等人[12]提出基于模态一致性的表示学习网络,显性利用文本特征和图像特征之间的交互,并通过随机潜在变量模型来共享跨模态信息。

(3) 基于模态重建的方法(Modality Reconstruction based Methods)

为了促进图文表示学习在潜在语义空间中的模态对齐,研究工作从模态对齐和数据增强两个方面将生成式对抗网络模型(GAN)应用于跨模态图文检索任务。一是利用GAN约束模态对齐。Wang等人[13]在JESR图文表示学习的基础上,提出了基于对抗策略的跨模态表示学习。在文本表示和图像表示之间施加一个模态分布对齐的目标函数来加快模型收敛速度,并且添加了跨模态翻译一致性的约束。为了探索在检索任务中篇章级文本生成图像的可行性,Bin等人[14]生成对抗网络用于食谱检索任务。Sugiyama等人[15]将图像信息分割成与文本相关的图像特征和与文本无关的形状特征,并基于形状特征和文本特征进行食物图像的模态重建。二是利用GAN实现数据增强。Guerrero等人[16]将文本数据翻译成多种语言对数据集进行扩充增强,并根据文本表示进行图像重建,约束文本表示中含有图像相关的信息。

未来发展:

事件密集型跨模态图文检索的应用场景愈加丰富,涉及教育、医疗、艺术、工业制造和材料研发等领域,具有较高的研究意义、商业价值与社会意义。其未来发展方向总结为以下3个方面:

(1)训练样本需求优化。 如何获取大规模、高质量的数据仍然是开展研究的一道门槛,未来可以利用弱监督、无监督、对抗生成学习和迁移学习等技术来克服训练样本数量需求的限制。

(2)检索效率优化。为了应对互联网日益增长的海量图文数据以及用户的实时响应速度需求,研究应考虑如何基于哈希索引等方法来将高维数据映射到低维的海明空间中,减小数据存储空间与检索匹配时的计算复杂度,提升检索效率。

(3)多语言检索场景。随着全球化进程的推进与互联网的发展,在社交媒体、课程教学等平台上会出现多语言共存的场景,且包含不同语言的文本数量常常是不均衡的,多语言跨模态图文检索是一个具有研究价值的问题。

参考文献

作者介绍

计算机术语审定委员会及术语平台介绍:

计算机术语审定委员会(Committee on Terminology)主要职能为收集、翻译、释义、审定和推荐计算机新词,并在CCF平台上宣传推广。这对厘清学科体系,开展科学研究,并将科学和知识在全社会广泛传播,都具有十分重要的意义。术语众包平台CCFpedia的建设和持续优化,可以有效推进中国计算机术语的收集、审定、规范和传播工作,同时又能起到各领域规范化标准定制的推广作用。新版的CCFpedia计算机术语平台(http://term.ccf.org.cn)将术语的编辑运营与浏览使用进行了整合,摒弃老版中跨平台操作的繁琐步骤,在界面可观性上进行了升级,让用户能够简单方便地查阅术语信息。同时,新版平台中引入知识图谱的方式对所有术语数据进行组织,通过图谱多层关联的形式升级了术语浏览的应用形态。

计算机术语审定工作委员会:

主任(代理):

李国良 (清华大学)

副主任:

王昊奋(同济大学)

主任助理:

李一斌(上海海乂知信息科技有限公司)

执行委员:

丁 军(上海海乂知信息科技有限公司)

林俊宇(中国科学院信息工程研究所)

兰艳艳(清华大学)

张伟男(哈尔滨工业大学)

委员:

柴成亮(北京理工大学)

彭 鑫(复旦大学)

李博涵(南京航空航天大学)

李 超(上海交通大学)

李晨亮(武汉大学)

杨 敏(中国科学院深圳先进技术研究院)

张 鹏(天津大学)

王昌栋(中山大学)

张宁豫(浙江大学)

孔祥杰(浙江工业大学)

术语投稿热线:ccfpedia@ccf.org.cn

返回首页

返回首页