CCF YOCSEF长沙于2023年9月24日,在中南大学校本部举办了以“AGI大模型潘多拉魔盒打开:革新还是威胁?”为主题的观点论坛。

本次论坛邀请到国防科技大学副研究员甘新标、中南大学特聘教授覃立波、湖南师范大学人工智能道德决策研究所研究员、中山大学计算机学院副教授王昌栋、湖南师范大学公共管理学院哲学系副教授孙保学、湖南设计数字研究院高级研究员贺成、NVIDIA教育与能源应用技术总监李顺、YOCSEF武汉现任主席肖奎、YOCSEF武汉AC叶正等嘉宾出席论坛,YOCSEF长沙的现任主席、副主席、AC委员十余人参加论坛。此次观点论坛由YOCSEF长沙AC张士庚和王森章共同担任执行主席。

图1 学界业界参会人员合影

首先,YOCSEF长沙现任主席陈果介绍了CCF YOCSEF的文化,强调了思辨讨论过程中的平等性、严格计时原则和思辨问话,随后论坛执行主席王森章介绍了举办此次论坛的背景。本次论坛将围绕AGI大模型给人类带来的革新与挑战一系列相关问题开展讨论。

图2 执行主席王森章介绍论坛背景

引导发言一:国产超算赋能的大图计算模型

图3 引导嘉宾甘新标发言

在引导嘉宾发言环节,甘新标表示,图计算作为大数据和智能计算的重要支撑,是天河超算的重要发展方向,其中,图分割算法的优化在图计算中非常重要,解决起来也很困难,需要更多的努力。

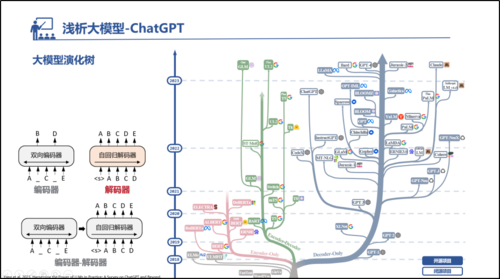

引导发言二:浅析大模型ChatGPT

图4 引导嘉宾覃立波发言

第二位引导发言嘉宾覃立波详细介绍了ChatGPT的发展演化历史,对ChatGPT的基本原理进行了介绍,同时针对GPT的涌现能力、思维链能力等进行了分析,并对大模型未来的发展方向进行了展望。

图5 覃立波讲解大模型演化

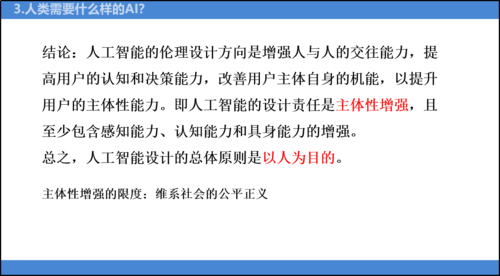

引导发言三:AGI大模型的伦理问题

图6 引导嘉宾彭理强发言

第三位引导发言嘉宾彭理强通过“中文屋”思想实验说明,符号化进路建构的机器,由于其自身无法获得符号的意义,成为人与机器难以逾越的“鸿沟”。为了弥补这个“鸿沟”,哲学理论界提出向机器植入人的价值观,试图建构一个人工道德主体实现人机价值对齐。但是彭理强认为,在设计这样一个人工道德主体时,至少存在道德知识、道德情感和道德意志三重设计困境,所以不管大语言模型将来是否可以发展为AGI,如果AGI中没有嵌入可解释的道德决策模型,其应用必然会产生人机责任分担的伦理困境。因此,如果机器中没有嵌入可解释的道德决策模块,道德行为的解释者只能属于设计者和使用者,在这个意义上的人工智能,其伦理设计方向应该是增强人与人的交往能力,提高用户的认知和决策能力,改善用户自身的机能,以提升用户的主体性能力。而这种程度的人工智能,正是目前产业界的发展现状。

图7 彭理强基于目前产业界人工智能发展现状总结“人类需要什么样的AI”

在思辨环节中,与会嘉宾针对此次论坛的主题进行了深入交流。

思辨议题一:针对人工智能领域的国际竞争,我们是应该加速大模型的研发,还是应该持更谨慎的态度,在没有扎好威胁“护栏”之前暂停或延缓开发?

针对这一话题,与会嘉宾展开了激烈的讨论。该议题的思辨嘉宾王昌栋论述了他的三个观点:第一,从克隆技术的发展来看,我们应该对研发保持乐观态度;第二,站在国内研究者的角度,我们不应该被国外学者的观点和看法误导,不能被带节奏,大模型研发要继续积极进行;第三,除了自然语言领域的大模型,我们还应该尝试从其他领域的大模型弯道超车,比如图数据的大模型。

图8 议题一思辨嘉宾王昌栋

部分与会嘉宾认为目前大模型还没有给人类造成实质性威胁,不应该暂停对大模型的研发。覃立波认为,我们不必太过担心大模型给人类的威胁,因为大模型的能力来源于人类的输入语料,研发者可以从数据源头控制它,保证研发的大模型是为人类服务的,是科技向善的。纪军刚认为,大模型的研发尚且处于初期阶段,应该大力发展,而不是被“制裁”。付绍静认为,虽然研发大模型存在危险,但也会带来很多意想不到的好处,我们不应该遏制研发,况且目前也没有明确的造威胁“护栏”的方法。部分嘉宾认为,应该保持谨慎态度,扎好大模型的威胁“护栏”。陈果认为,大模型的能力可能超出人类掌控。王森章认为,大模型的研发应该缓一缓,要加强与之配套的监管机制建设。叶正认为,大模型对社会的威胁已经出现了,导致比如造成人们失业等问题,应该做好大模型的威胁“护栏”。姜文君认为,大模型确实会存在一定风险,需要从法律方面来引导,从各个层面来做护栏。还有观点认为,不应该简单暂缓发展大模型,大模型的研发与扎好威胁“护栏”应该同步进行。张士庚认为,如果我们不发展大模型,可能就会受到国外研发的威胁,在发展大模型时要扎好护栏,不然可能会受到攻击和威胁。娄小平认为,所有的技术带来好处的同时都会带来一定的危险,我们应该一边做好研发,一边做好监管。

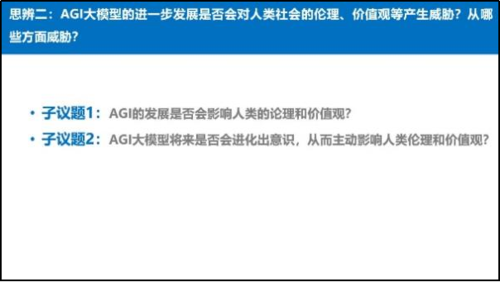

思辨议题二:AGI大模型的进一步发展是否会对人类社会的伦理、价值观等产生威胁?

图9 议题二思辨嘉宾孙保学阐述个人观点

针对这一话题,与会嘉宾展开了激烈的讨论。该议题思辨嘉宾孙保学主张AGI大模型的发展不会对人类社会的伦理、价值观等产生威胁。他认为,一方面,每次技术革新都带来很多问题,但我们社会至今还是很稳固,大模型对现有社会的影响有限,不会产生根本性的影响,也无法颠覆社会,还远没有达到黑死病、新冠疫情等的影响程度。另一方面,大模型不会改变底层逻辑,只是增加新元素,它能大大提高生产效率,与其担忧技术不如反思人本身,不必杞人忧天。此外,他认为技术根植于社会,它不是病毒,监管的应该是人而不是技术,过早过度的监管会遏制创新。AI迟早能发展出意识,但不是与人类一样的意识,是不同维度的体现,不会走向对立与对抗。

部分与会嘉宾也持相同态度,认为AGI大模型的发展不会影响到人类社会的伦理、价值观。覃立波认为,AI目前来看不太会进化出意识,目前它还处于初级阶段,不跟外部环境直接交互很难产生意识。部分嘉宾认为,AGI大模型的发展可能会对人类社会的伦理、价值观等产生威胁。陈荣茂认为, AI肯定会对人类有隐私方面产生威胁,数据来源和拥有权本身也非常重要。王森章认为,意识是否有明确的定义?GPT4比国内目前使用的ChatGPT要强大许多,GPT4可能已经产生了部分意识。还有观点认为,AGI大模型对人类带来威胁与否,与人类的引导有关。欧阳雪认为,更应该担心引导人类失控的技术,害怕大模型产生自主意识。刘贝迪认为,价值观有好坏之分,人类如何引导AGI大模型很重要。彭理强认为,技术是改变生活的方式,价值观会受到技术发展的影响,伦理和价值观要跟上时代与技术的发展,如何引导大模型是人类应该考虑的问题。

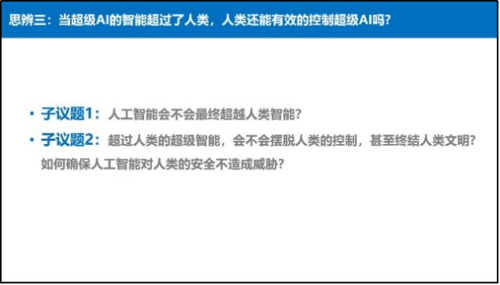

思辨议题三:当超级AI的智能超过了人类,人类还能有效的控制超级AI吗?

图10 议题三思辨嘉宾贺成、李顺阐述个人观点

该议题的思辨嘉宾贺成认为,如果不受限制发展大模型,超级AI有很大的可能性会超过人类智能,从目前已有大模型的表现来看,其进化速度很快。当它超过人类智能的时候,我们只能发展另外的模型与之对抗。其次,人工智能对就业的影响是必然的趋势,要看技术在什么层面去模仿,人有创新能力,机器擅长模仿。此外,他认为,不是说人类文明一定是最高级的文明,人类是从低级的猩猩进化出来的,人的自我意识高于其它物种因此可以主宰地球,同理,一旦出现新的物种高于人类文明,可能会终结人类文明。

思辨嘉宾李顺认为,首先,当机器的配置足够高,运算足够快的时候,人工智能超过人类智能也是很正常的。其次,超过人类的超级智能会摆脱人类控制,机器模型本身也会不断迭代发展。人类在研究超级智能的过程中,要学会怎么去控制它。陈果认为,人工智能对就业的影响很大,人工智能超过人类智能会导致很多行业的失业。肖奎认为,不管从技术还是产品的角度来说是,人工智能都有可能会超过人类智能。人工智能的发展不仅仅是大模型本身,大模型所延伸出来的东西也会影响人类。也有观点认为,人工智能不会超过人类智能,或者即使超过了人类,人类依然能有效地控制超级AI。孙保学认为,即使人工智能超越人类智能,它也不会消灭人类的文明,人类是AI的创造者,为人工智能的存在奠定基础,人工智能是依赖于人类的,就像我们依赖大自然一样。还有部分观点认为,人工智能会超过人类智能,人类可能会失去对超级AI的控制。王昌栋认为,人工智能比人类更聪明,肯定会摆脱人类的控制。陈果认为,人工智能可能会极大改变人类的生活方式,人类文明看似被终结了。杨超认为,AI想要接近人类智能,仍然需要在真实环境的交互中进化出更高层次的语言理解能力、共情能力、生成能力和决策能力,在这个过程中,AI群体的局部交互有可能会涌现出整体智能,从而影响最终决策。

最后,论坛主席王森章对本次论坛进行总结,通过不同研究领域的学者以及工业界的专家对大模型展开的激烈讨论,加深了大家对大模型的理解,对大模型未来的发展机遇和挑战也有了更全面的认识。

图11 论坛嘉宾合影