2023年12月23日下午,由中国计算机学会(CCF)主办,CCF YOCSEF深圳承办,英特尔大湾区科技创新中心协办的"AI AGENT:大模型时代的玩具还是下一个爆点?"(论坛编号:CCF-Yo-23-177)技术论坛以线上线下的方式顺利举办,线下举办地址为深圳市南山区英特尔大湾区科技创新中心18楼中教室。这次活动是YOCSEF第一个讨论AI Agent的论坛,论坛邀请了CCF杰出会员\清华大学教授袁春,清华大学副教授\鹏城实验室双聘副教授郑海涛,北京大学助理教授\博导袁粒和腾讯AI LAB高级研究员吴秉哲作为引导发言嘉宾,YOCSEF深圳AC委员、候任AC委员及委员近三十人在深圳线下参加论坛,腾讯Wiz直播在线PV有2196,参加人数有1269人(点击观看回放)。论坛活动由CCF YOCSEF深圳AC委员\智平方科技战略负责人莫磊,CCF YOCSEF深圳AC委员余冰担任执行主席,CCF YOCSEF深圳AC委员、哈尔滨工业大学助理教授漆舒汉担任线上主席。

会议伊始,CCF YOCSEF深圳主席张伟鹏向嘉宾们简要介绍了CCF YOCSEF的文化,包含了YOCSEF的含义、创办目的,YOCSEF组成、定位、论坛规则等内容。

莫磊首先进行论坛背景介绍:从CHATGPT出来已经一年多了,业界快速发展,大家对大语言模型了解更加深入,也在探索大语言模型的下一个爆发点,其中AI Agent就是其中最热门的话题。但Agent并不是新的概念,Agent从哲学中来,而人工智能领域的Agent 是一个计算实体,能够使用传感器感知周围环境、做出决策,然后做出行动。Agent的研究经历了很多阶段,依次经历了Symbolic Agent、Reactive Agent、RL-based Agent、Transferrable Agent直到今天的LLM-based Agent。大语言模型背景下,Agent代表能够自主理解、记忆、规划、做出决策的智能体。今天的论坛聚焦面向数字世界的Agent,关注LLM-based Agent的能与不能。

随后进入嘉宾引导发言环节。袁春以《复杂场景下多智能体的对手-环境建模》为题,介绍了RLHF对ChatGPT的重要性、复杂场景下对手建模的方法以及在游戏场景中突出的实验结果。让大家了解强化学习对Agent的重要性。

郑海涛以《迈向认知智能:人工智能体的潜力与局限探究》为题,介绍了LLM-based Agent的研究动机、框架、应用场景、局限等内容。让大家对LLM-based有了全面的理解。

袁粒以《大语言模型垂直领域应用浅析》为题,介绍了大语言模型的垂直模型ChatLaw的实现方式、如何在实际应用场景中减轻幻觉等学术与产业相结合的问题,让大家了解垂直领域Agent在使用中的难点以及未来的研究方向。

吴秉哲以《AIGC风险治理智能体的探索》为题,介绍了大模型的风险概览、大语言模型风险自动化测试以及基于Agent的社会偏见风险治理,从Agent产业落地的角度给大家很多启发。

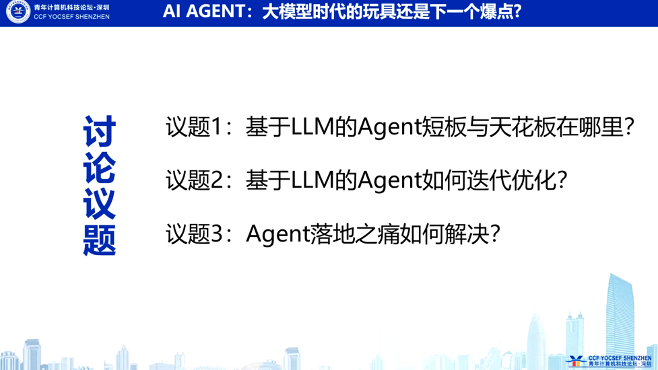

接下来,莫磊和余冰主持了思辨环节,在场嘉宾就三个思辨问题进行了激烈的讨论

南方科技大学副教授郑峰和哈工大深圳副教授汤步洲为此环节提供了思辨引导发言。郑峰指出,视觉领域的研究者正将焦点转向Agent,并提出了一个关键问题:具身智能是否会成为人工智能的最终形态。他观察到,无论是在语言还是视觉领域,研究都正逐渐汇集到Agent的概念上。汤步洲则强调了LLM在解决各领域问题方面的优势,同时指出了其局限性。他提出了一个关键的疑问:仅仅将所有数据集中到一个模型中,真的能解决所有问题吗?他指出,尽管使用LLM可以重塑业务流程,但这种方法很快就会遇到天花板,回归到没有大模型时代的同样问题。

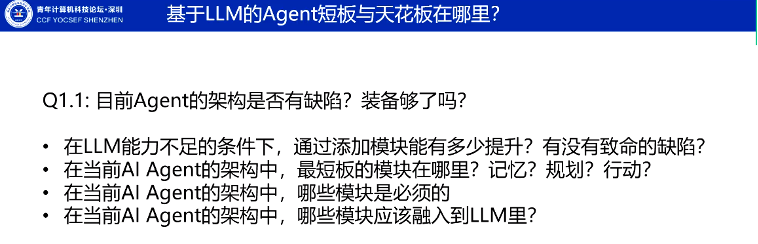

莫磊主持了第一个议题的讨论“基于LLM的Agent短板与天花板在哪里”。莫磊解释到,Agent就像是LLM不停加装备增强的样子。业界越来越多的讨论倾向于把Agent看成是以LLM作为大脑并依次加入了memory、planning、tools模块的复杂系统。第一个子议题是“目前Agent的架构是否有缺陷?装备够了吗?”

郑海涛:他认为目前的Agent架构不完备,缺乏统一的规范。他特别强调了Agent在领域知识提升方面与LLM的区别,以及如何深入理解领域知识的挑战。Agent对领域知识、领域逻辑深入理解,还是个空白领域。

余冰:他探讨了知识的来源和如何将其融入Agent,认为最核心的挑战是如何有效地处理知识,而不仅仅是Agent的工具或记忆模块。

袁粒:在讨论LLM能力的不足时,他提到了强化学习的重要性,并探讨了单Agent向多Agent的发展有机会激发更多潜能。

郑峰:他指出,尽管大模型无法完全覆盖所有Agent的应用场景,但语言模型的架构本身并没有太大问题。他还讨论了人类语言知识与视觉知识的关系。现在人类所拥有的语言知识某种程度上其实是对所有视觉知识的一种总结,人是通过中枢控制的,模型却是通过各种任务训练的,这是很大的一种区别

黄典:她谈到了大模型对计算资源的巨大需求,与人脑的小样本学习方式的不同,通过这样堆积算力的方式打造Agent和实现AGI有很大问题

吴秉哲:他提出了打开LLM“黑盒”的必要性,并指出LLM在长文本理解和生成能力上的缺陷。还需要一个World Model帮助Agent理解世界

袁春:他总结了Agent当前面临的几对矛盾,包括视觉与语言的发展、大模型的可解释性、强化学习与普通网络模型的关系,以及数据与模型规模的增长。

邱宇轩:他指出大模型主要基于语言,但现实世界的知识远比语言丰富。现实世界的知识包括视觉、操作等其他知识,可能眼睛学会了,手没学会。大脑也是有分区的,一个基座模型可能没办法处理所有事情。

汤步洲:他强调了理解大模型中知识产生机制的重要性,以及当前模型输出质量的问题。当前的Agent的短板LLM缺乏行业知识的,而行业知识不应该作为外挂装备的方式存在,而应该融入到LLM里面。同时传统解决推理问题的事例图谱等方法也应该融到LLM里面去,作为外挂Planning模块有很大的局限性

第二个子议题是“如何解决LLM幻觉与Agent任务确定性之间的矛盾问题?”

袁粒:他指出幻觉确实是一个问题,且业界正在努力突破这一难题。进一步强调,解决幻觉问题时必须考虑到特定场景的特点和服务对象。他强调了定义问题的重要性,并指出幻觉与创造性之间存在显著关联。在无法准确定义问题之前,工业界只能选择妥协处理。

郑海涛:他将幻觉分为两类:事实类幻觉和推理类幻觉,并介绍了两种解决路径:CUT和PUT。郑海涛指出,尽管CUT可能在处理事实类幻觉时有效,但推理类幻觉更难解决。他提到,LLM在基于现有人类知识进行推理时呈现出黑盒特性,而PUT方法在数学问题上已显示出很好的解决潜力。

疯子和天才只有一线之差,大模型的创造性和幻觉很可能是相辅相成的

余冰主持了议题二的讨论“基于LLM的Agent如何迭代优化”。两个子议题分别是“当前AI Agent的评价标准应该如何制定?”,“当前AI Agent的能力应该如何去优化”

吴秉哲:他强调迭代优化的重要性,认为必须建立商业闭环并实现落地应用。吴秉哲提出,评价标准应深度绑定到实际应用场景,目前的benchmark过于偏向学术研究。他建议从用户出发,使用众包测试来评估,并提到ChatGPT在根据用户反馈制定标准方面做得很好,强调了从数据科学角度分析用户体验的重要性。

郑海涛:他讨论了AI感知问题,指出语言是一种感知能力,可以通过语言反推视觉。郑海涛认为,优化语言能力是关键,并能辅助视觉能力。他强调了规划(planning)的重要性以及预测能力的不足,并提出标准应结合用户数据和行业需求。

袁春:他强调了强化学习在Agent优化中的应用,包括强化学习中的关键技术如时间差分(TD)学习、马尔科夫决策过程、贝尔曼方程等能够帮助Agent进行迭代优化。但将这些理论与大模型结合是当前的一个挑战。

吴秉哲:他探讨了如何定义奖励模型,并指出需要有一个世界模型来定义奖励。吴秉哲以AI手机为例,说明了在具体领域中,AI如何通过推荐系统产生商业价值并获得奖励。

莫磊主持了议题三的讨论“Agent落地之痛如何解决?”,前两个子议题分别是“能否解决对单一LLM依赖过高的问题?”,“当前Agent的应用效率和使用成本如何解决?”

郑海涛:他讨论了Agent在多个底座上的应用和其带来的成本问题。郑海涛强调,市场到底需要什么,以及如何落地Agent是一大挑战。他指出,落地的一大门槛是需要行业专家的配合,并且要将专家用于解决痛点问题的逻辑传达给Agent。

袁粒:他最近与创业者交流发现,虽然大模型通常不收费,但数据是更加珍贵的资产。袁粒提出,为了获得珍贵的数据,大模型底座厂商可能会选择免费开放大模型。

鲁浩楠:他从实际应用的角度出发,讨论了效果、迭代、成本和未来趋势。鲁浩楠提到,以Agent落地手机来看,针对普通用户的需求并不复杂,强调了手机原生项目的重要性,以及在百万级以上量级用户情况下的成本问题。

最后一个子议题“OpenAI发布GPTs,对Agent的生态产生何种影响?”

尚志强:作为来自投资界的代表,他认为GPT对Agent普及有正向作用,更关注群体智能和多Agent的交互。尚志强指出,目前国内关于Agent的创业相对较少,GPT4对Agent的冲击可能促进开源体系中Agent的发展。

最后莫磊对论坛进行总结,目前看Agent的短板并不是外部装备,还是LLM作为大脑本身的知识的匮乏,难以直接在各行各业中直接使用,而未来这些知识不应该作为外挂装备而应该更好地融入到LLM中去;面对Agent应用中LLM产生的幻觉问题,当前最有效的手段是限制使用场景、条件,同时使用者应该对Agent的使用有足够的认知;LLM-based的Agent当前来看落地仍然有很多的局限性与不确定性,如果对标大规模使用的产品,当前的Agent更像是玩具,但是无疑是大语言模型后的下一个重要发展方向。