报名 | 第六届 语言与智能高峰论坛 Language & Intelligence Summit

一、论坛简介

中国计算机学会和中国中文信息学会联合创办了“语言与智能高峰论坛”,每年举行一次,首届论坛于2016年在北京举行,已成功举办五届。通过高峰论坛,旨在向社会公众介绍国际语言与智能及相关领域的发展趋势和创新成果,进一步推动我国语言与智能技术领域的发展。

论坛邀请了国内外相关领域的资深专家学者,共同探讨语言与智能领域的新发展和新技术。本届论坛还设立了青年科学家论坛、企业论坛,以及语言与智能技术评测论坛,邀请优秀青年学者、企业嘉宾及技术专家进行思想碰撞与探讨。

二、报名方式及费用

报名、注册缴费链接如下:

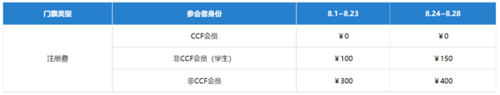

CCF会员免费参会,非CCF会员参会价格如下:

三、日程安排

2021年8月28日 8:45-18:15(线上)

08:45-09:00 | 开幕式 | |

09:00-09:50 | 特邀报告:孙茂松(清华大学) 报告题目:坐看云起时:自然语言处理的迷思

摘要:以2010年深层神经网络在语音识别研究方向上取得里程碑式进展为新起点和新动能,整个人工智能领域迅速跃迁到深度学习时代。这也涵盖了人工智能最为重要的分支领域之一——自然语言处理。最近十年间,深度学习在自然语言处理几乎各个研究方向上均显著提升了其性能水平,近年来更发展到以BERT和GPT3为代表的大规模预训练语言模型,并且“出乎意料”地成为世界范围内整个人工智能领域技术竞争的战略焦点和热点,引领了一个时期的潮流(如各类预训练语言模型以及预训练多模态模型如雨后春笋般层出不穷)。基于深度学习的自然语言处理正沿着“极大数据、极大模型、极大算力”的轨道“无所不用其极”地一路奋进,但这条路走到极致,前景又会是怎样的呢?是否会放眼看过去大面上热热闹闹,“乱花渐欲迷人眼”,但在研究以及真正解决问题的深刻程度上,却沉迷停留于“浅草才能没马蹄”的阶段?本报告拟就此类迷思进行一些不成熟的“放飞式”讨论。

孙茂松,清华大学计算机科学与技术系教授、博士生导师,清华大学人工智能研究院常务副院长,清华大学计算机学位评定分委员会主席,欧洲科学院外籍院士。2007-2018年任该系系主任、党委书记。主要研究领域为自然语言处理、人工智能、社会人文计算和计算教育学。国家重点基础研究发展计划(973计划)项目首席科学家,国家社会科学基金重大项目首席专家。北京智源人工智能研究院自然语言处理重大研究方向首席科学家,中央音乐学院、青海师范大学兼职教授、博士生导师,新加坡国立大学访问教授。在重要国际刊物、国际会议、国内核心刊物上发表论文200余篇,Google Scholar论文引用18500次以上。主要学术兼职包括:教育部在线教育研究中心副主任,清华大学大规模在线教育研究中心主任,清华大学-新加坡国立大学下一代搜索技术联合研究中心联席主任,国务院学位委员会第六、八届计算机学科评议组成员,教育部教学信息化与教学方法创新指导委员会副主任委员,互联网教育智能技术及应用国家工程实验室副主任,中国科学技术协会第九届全国委员会委员,中国中文信息学会第六、七届副理事长,《中文信息学报》主编,《数字人文》共同主编,全国计算机慕课联盟副理事长等。2016年获“全国优秀科技工作者”。2020年获教育部高等学校科学研究优秀成果奖(科学技术)一等奖、钱伟长中文信息处理科学技术奖一等奖、教育部高等学校科学研究优秀成果奖(人文社会科学)二等奖。享受国务院政府特殊津贴。

| |

09:50-10:40 | 特邀报告:Pascale Fung(香港科技大学) 报告题目:A Technical Approach to Ethical NLP

摘要: Natural language processing systems, ranging from Conversational AI to machine translation, have made leaps and bounds in terms of performance with generative models based on language models. Thanks to the advent of large scale pre-trained language models, state-of-the-art NLP systems can generate surprisingly human-like sentences and paragraphs. However, these generation based systems are difficult to control and can lead to inappropriate, biased and sometimes even toxic texts. We also lack the means to measure the inherent knowledge, common sense and biases in the large-scale pre-trained language models. With great power comes great responsibility. We must address the many ethical and technical challenges of generation based NLP systems to control for bias and safety, guard against abuse and promote social harmony. In this talk, I will discuss the various challenges in operationalizing ethical AI in general, and NLP systems in particular, in the context of the ethical AI principles proposed by the governments of China and the European Union. I will give an overview of the state-of-art of technical approaches in ethical NLP and discuss future directions.

Pascale Fung is a Professor at the Department of Electronic & Computer Engineering and Department of Computer Science & Engineering at The Hong Kong University of Science & Technology (HKUST), and a visiting professor at the Central Academy of Fine Arts in Beijing. She is an elected Fellow of the Association for Computational Linguistics (ACL) for her “significant contributions towards statistical NLP, comparable corpora, and building intelligent systems that can understand and empathize with humans”. She is a Fellow of the Institute of Electrical and Electronic Engineers (IEEE) for her “contributions to human-machine interactions”, and an elected Fellow of the International Speech Communication Association for “fundamental contributions to the interdisciplinary area of spoken language human-machine interactions”. She is the Director of HKUST Centre for AI Research (CAiRE), an interdisciplinary research center on top of all four schools at HKUST. She co-founded the Human Language Technology Center (HLTC). She is an affiliated faculty with the Robotics Institute and the Big Data Institute at HKUST. She is the founding chair of the Women Faculty Association at HKUST. She is an expert on the Global Future Council, a think tank for the World Economic Forum. She represents HKUST on Partnership on AI to Benefit People and Society. She is on the Board of Governors of the IEEE Signal Processing Society. She is a member of the IEEE Working Group to develop an IEEE standard - Recommended Practice for Organizational Governance of Artificial Intelligence. Her research team has won several best and outstanding paper awards at ACL, ACL and NeurIPS workshops.

| |

10:40-10:50 | 中场休息 | |

10:50-12:20 | 青年科学家论坛 | |

10:50-11:20 | 青年科学家报告:张奇(复旦大学) 报告题目:自然语言处理中的鲁棒性

摘要:深度神经网络在几乎全部自然语言处理任务中都取得了非常好的效果,在包括阅读理解在内很多任务的标准评测集合上达到了超越人类的准确性。然而,我们在实际应用中确发现,在真实场景中很多模型的效果大打折扣,所获得精度甚至远远低于传统机器学习方法。近年来的很多研究也表明,深度神经网络模型在仅仅添加了很小的扰动的样本上,其预测效果也很可能出现大幅度下降。模型鲁棒性的研究也因此受到越来越多的关注。在本次报告中,将针对自然语言处理算法的鲁棒性问题,在语料构建、文本表示、模型分析、鲁棒性评测等方面的最新研究进行介绍。

张奇,复旦大学计算科学技术学院教授、博士生导师。主要研究方向是自然语言处理和信息检索。以第一作者或通讯作者发表论文共100 余篇,被引用次数3000余次。获得WSDM最佳论文提名奖、COLING最佳论文提名奖。作为第二译者翻译专著《现代信息检索》。获得上海市科技进步二等奖、教育部科技进步二等奖、ACM 上海新星提名奖、IBM Faculty Award、中国中文信息学会钱伟长中文信息处理科学技术奖--汉王青年创新一等奖。

| |

11:20-11:50 | 青年科学家报告:夏睿(南京理工大学) 报告题目:文本中的情绪与原因联合抽取

摘要:当前有两个主要的文本情绪分析任务:一个是情绪识别,其目标是从人类心理学的角度识别文本中人们表达的情绪类型(如喜怒哀乐等);另一个是情绪原因抽取,其目标是分析和抽取文本中某些情绪表达背后的潜在原因。针对当前研究中存在的问题,首先提出了情绪原因动态抽取、情绪原因同步抽取方法,在此基础上提出了一项新的情绪与原因配对抽取任务,并相应提出了情绪与原因配对分合抽取、情绪与原因配对端到端抽取等多种方法,在情绪原因分析基准语料库上的实验证明了任务的可行性和方法的有效性。最后对本领域的未来工作进行展望。

夏睿,南京理工大学计算机学院教授、博士生导师。研究领域为自然语言处理和文本情感计算。在人工智能、自然语言处理、数据挖掘领域的国内外重要期刊和会议发表论文60余篇、出版学术专著2部,获得ACL2019杰出论文奖、COLING2020最佳论文候选、中国中文信息学会钱伟长中文信息处理科学技术奖——汉王青年创新奖一等奖和江苏省杰出青年基金资助。

| |

11:50-12:20 | 青年科学家报告:郭嘉丰(中科院计算所) 报告题目:面向信息检索的预训练语言模型

摘要:近年来,“预训练-调优”范式在自然语言处理领域取得了显著的成功,基于自监督任务训练得到的BERT等预训练模型在诸多自然语言理解的下游任务上取得了最优性能。目前,预训练语言模型也被信息检索领域广泛采纳,在实际Web搜索系统中发挥了重要作用。然而,已有的预训练任务和检索的契合度不高,导致预训练模型在排序任务上获得的提升不够显著,如何构建契合信息检索的预训练任务成为一个值得探索的科学问题。在本次报告中,我将首先介绍当前预训练模型在信息检索系统的主要应用与效果,并进一步介绍近期在面向信息检索的预训练方法上最新的研究成果。

郭嘉丰,博士生导师,中科院计算技术研究所研究员,中国科学院大学岗位教授,现任中科院网络数据科学与技术重点实验室常务副主任,国家优青获得者,中科院青促会优秀会员,北京智源学者,联想青年科学家。长期从事智能信息检索与大数据分析方向研究。发表学术论文100余篇,Google Scholar累计引用7000余次,获得CIKM 2011最佳论文奖,SIGIR 2012最佳学生论文奖, CIKM 2017最佳论文Runner-up奖。担任本领域国际重要学术期刊ACM TOIS、IRJ编委以及主要国际会议的程序委员会高级评审委员、委员等。相关成果获得2020年国家技术发明二等奖(待批)、2012年国家科技进步二等奖、2012年中国中文信息学会 “钱伟长中文信息处理科学技术奖——汉王青年创新奖”一等奖。

| |

12:20-13:30 | 午休 | |

13:30-14:30 | 评测报告 | |

14:30-16:10 | 圆桌论坛:大而强 VS 小而美:自然语言处理模型该如何演进? 主持人:史晓东(厦门大学) | |

14:30-14:35 | 开场报告:史晓东(厦门大学) 报告题目:大而强 VS 小而美:自然语言处理模型该如何演进? | |

14:35-14:45 | 主题引导报告:白硕(恒生电子) 报告题目:探索无规则的符号系统 摘要:1、无规则的符号系统是可能的;2、这样的系统一样可以具有泛化性和鲁棒性;3、这样的系统甚至可以在无监督情况下做到数据驱动;4、这样的系统是可解释的。 白硕,恒生研究院院长,中科院计算所、信工所兼职博导,中国中文信息学会常务理事,中国计算机学会上海分部主席。曾任中国中文信息学会信息检索与内容安全专委会主任委员,上海证券交易所总工程师。 | |

14:45-14:55 | 主题引导报告:周明(创新工场) 报告题目:小模型还是大模型?从计算机求解美国司法学院入学考试题谈起

摘要:我通过美国司法学院入学考试LSAT中的三种任务(分析推理、逻辑推理和阅读理解)任务来探讨小模型(这里指符号方法)和大模型(这里指大规模预训练模型)以及两者结合的方法,以此探究未来NLP的研究方向。

周明,现任创新工场首席科学家并于2021年6月创办了澜舟科技。澜舟科技该公司致力于开发最先进的下一代认知智能技术,包括自然语言和多模态信息的理解和生成、机器翻译、知识图谱、问答和推理、行业搜索、知识服务等技术。最近,澜舟科技开发的轻量化预训练模型(孟子)居中文NLP权威评测CLUE的榜首。周明是中国计算机学会副理事长、中国中文信息学会常务理事。他曾任微软亚洲研究院副院长、 国际计算语言学协会(ACL)主席。他还担任哈工大、天津大学、南开大学、北航、中国科技大学等高校的博士导师。他是2018年首都劳动奖章获得者。他长期从事NLP研究,发表了90篇左右的ACL文章(H-index 84)。 | |

14:55-15:05 | 主题引导报告:吴华(百度) 报告题目:预训练模型的未来进化:直觉和理性的融合 摘要:大规模参数预训练模型基于大数据,学习到了通用的人类直觉智能,这是基础系统;而更高级的逻辑推理和智能决策,需要通过高级系统更新学习机制,学习到高级逻辑和决策机制,两个系统相互作用,持续进化。

吴华,百度技术委员会主席,主要从事自然语言处理领域的研究,其主持研发的多项核心技术被广泛应用于翻译、搜索、智能音箱、地图等产品,并赋能各行各业。曾获国家科技进步奖二等奖、中国专利金奖;被评为杰出工程师、青年北京学者等。

| |

15:05-15:15 | 主题引导报告:蒋欣(华为) 报告题目:预训练模型能否替代符号计算模型? 摘要:数据驱动的预训练深度模型,通过神经符号计算技术的引导,可能会越来越多的取代符号计算模型并在工业中实用。 蒋欣,华为诺亚方舟实验室资深研究员、语音语义实验室主任,负责语音和自然语言处理领域的前沿研究和技术创新,研究方向涵盖预训练语言模型、对话问答系统、机器翻译、语音和多模态学习等。蒋欣博士毕业于北京大学数学科学学院,2013年加入华为诺亚方舟实验室。加入华为前,曾就职于网易有道和百度。蒋欣在自然语言处理、机器学习和信息检索等领域的国际会议和期刊上发表论文50余篇,专利10余件,引用1600余次。

| |

15:15-15:25 | 主题引导报告:张家俊(中科院自动化所) 报告题目:从中文GPT实践的角度看NLP通用模型 摘要:本报告将从讲者进行中文GPT研究的一些实践,介绍NLP通用模型探索中模型规模、任务类别以及语音和视觉等多模态信息的影响。

张家俊,中国科学院自动化研究所研究员、博士生导师,智源青年科学家,主要研究方向为机器翻译和自然语言处理。发表CCF-A/B类论文60余篇,出版学术专著2部,6次获得最佳/优秀论文奖,3次被评为IJCAI、ACL和NAACL的杰出SPC和审稿人。入选2015年中国科协首届青年人才托举工程,获得钱伟长中文信息处理科学技术奖一等奖、青年创新奖一等奖、2019年新疆维吾尔自治区科技进步奖二等奖。担任中国中文信息学会机器翻译专委会副主任、青年工作委员会副主任。担任ACL/EMNLP/COLING的(资深)领域主席,担任期刊《Machine Translation》、《自动化学报》和IJAC的编委。

| |

15:25-16:10 | 圆桌讨论 | |

16:10-16:20 | 中场休息 | |

16:20-17:10 | 特邀报告:吴玺宏(北京大学) 报告题目:一种具身发展式语言学习框架——从语音到发声姿态的反演示例 摘要:在深度学习技术的推动下,随着语音标注数据规模的巨量化,机器语音识别取得了令人瞩目的进展。种种迹象表明语音识别性能已显露出“天棚”现象,而且在方言和小语种语音识别方面尚无有效的解决方案。报告对语音识别任务的工作假设进行反思,基于具身认知主义,结合机器人、机器视觉和机器听觉的研究进展,提出一种具身发展式语言学习框架。作为该框架的核心之一,基于听觉的“肌动理论(Motor Theory)”,提出了一种结合发声物理模型的非监督自主学习方法。通过正向物理模型和逆向听觉模型的迭代学习,实现了从任意非标注语音到声门激励信号和发声姿态参数的推断,推断结果对语音的描述具有可解释性;通过在线自适应可实现对新语音的发声姿态推断,解决了模型学习的泛化问题。基于发声姿态可进一步实现任意语种的音系构建,为小语种和方言的语音识别、个性化语音合成任务提供了一个新的解决思路。 吴玺宏,男,汉族,北京大学教授、博士生导师。现为北京大学信息科学技术学院副院长、智能科学系主任、言语听觉研究中心主任。长期致力于机器听觉计算理论、语音信息处理、自然语言理解以及智能机器人等领域的基础及应用基础研究。先后主持和参与国家级、省部级项目40余项,包括国家973课题、863项目、国家科技重大专项、国家科技支撑计划、国家自然科学基金重大项目及重点项目、国家社会科学基金重大项目等。获国家授权发明专利11项,发表学术论文200余篇。

| |

17:10-18:00 | 特邀报告:Mark Steedman(爱丁堡大学) 报告题目:Building and Interrogating Knowledge Graphs in Natural Language

摘要:Building knowledge graphs from text and querying them in natural language has always been an attractive idea, as avoiding the need for an expert to mediate between naive users and standard data-base and knowledge-graph knowledge representation languages such as SQL and SPARQL. The problem has always been that there is no usable semantics for natural language, nor any inference system based on it that will in practise get us from the text or the corresponding knowledge graph to an answer to the question.

There are two contemporary approaches to this problem. Themachine-reading approach seeks, by parsing large amounts of unlabeled multiply-sourced text, to extract natural language predicates grounded in n-tuples of linked named entities, forming a large Knowledge Graph whose nodes are the entities and whose arcs are the predications. Directed meaning postulates over those predicates are then extracted form the Knowledge Graph, based on distributional inclusion between the sets of entity tuples for each pair of predicates, to form a second Entailment Graph.

The alternative approach treats vector embeddings, pre-trained on even larger amounts of text, as embodying a latent form of entailment graph, revealed using supervised fine-tuning of a large contextualized Language Model such as BERT and its descendants over corpora consisting of examples of entailment.

The talk will report progress and results from building a large entailment graph and using it to interrogate knowledge graphs built with the same predicate relations. It will also compare it with recent results from the alternative language-model based approach.

Mark Steedman is a Professor in the School of Informatics at the University of Edinburgh. His research is at the interdisciplinary interface of computer science and theoretical psychology in natural language processing (NLP) and Artificial Intelligence (AI). It proceeds from the conviction that language and cognition are inherently computational. His achievements include: advancing the theory of grammar; robust wide-coverage statistical semantic parsing; combined logical and distributional semantics; temporal semantics; and the structure and meaning of intonation in speech. He has pioneered the application of NLP methods to the analysis of music, and the use of AI models in understanding their common evolutionary origin.

His most widely recognised invention is Combinatory Categorial Grammar (CCG), a computationally practical theory of natural language grammar and processing (Steedman 1985b, 1987a, 1996a, 2000a, 2012a). This work has been recognized in its linguistic aspect by a Fellowship of the British Academy, and in its applied aspect, by Fellowships of the American Association for Artificial Intelligence (AAAI), the Association for Computational Linguistics (ACL), and the Cognitive Science Society. In 2018, Steedman received the Lifetime Achievement Award of the ACL.

In work at the Universities of Sussex, Warwick, Pennsylvania, and Edinburgh, Steedman has pioneered the use of CCG as a practical basis for statistical natural language processing applications involving theoretically and computationally challenging linguistic phenomena. He has also shown that the same class of grammatical rules and statistical models is both necessary and sufficient for the analysis of harmonic and rhythmic structure in music, and that both language and music have their its origins in pre-linguistic multi-agent action-planning. The impact of this work is evident in its adoption by industrial laboratories. His students are employed at Google, Facebook, DeepMind, Apple, and Amazon, as well as on the faculties of the world's leading universities.

| |

18:00-18:15 | 闭幕式 |

四、会议网站

http://tcci.ccf.org.cn/summit/2021/index.php

欢迎大家踊跃报名参会

相关阅读:

注册报名: HTTPS://CONF.CCF.ORG.CN/WEB/HTML4/INDEX.HTML?GLOBALID=M8572863974957424641624434604774&TYPE=1

2021第六届语言与智能峰会论坛网址:

http://tcci.ccf.org.cn/summit/2021/index.php

2020第五届语言与智能高峰论坛网址:https://conference.cipsc.org.cn/lis2020/index.html

2020第五届语言与智能高峰论坛 回放视频:https://hub.baai.ac.cn/view/3864

返回首页

返回首页